いつも思うのですが、このように備忘録を書きながら作業すると、なんのためになにをやっているのかがはっきりするので自分のために役立っています。

LLMをローカルで動かすべくminiPCを購入したことは以前書きました。

ちなみに「AIを使うためにminiPCなんて馬鹿じゃねーの」といっている人がいるので、こっそり反論しておきます。

miniPCの導入記録にも書きましたが、AMD Ryzen9 8945HSを使っている時に限って、`miniPCを買うことは悪い選択ではないと思います。たしかにAMDのGPUのRadeonシリーズはマイナーです。でもAIの世界の環境でサポートされているものは少なくない。(Pytorchはだめだけど)OllamaではAMD GPUは使えるようになっている。

最も重要なことはRyzenn 9は8945HS GPUとCPUがメモリーを共有している。この構成からAMD Ryzen 9はBIOS設定でGPUとCPUのメモリー割当を変えることができる。実際に、私はGPUに16GBを割り当てている。インテルも内蔵GPUにメモリー割当られますよと言っているが512MBなど単位が違う。実際、24BクラスのLLMモデルならば、全部GPUに収納でき、かなり早く動く。

さらにAMD Ryzenは、まだ誰もサポートしていないNPUも搭載しています。ドキュメントがほとんどないけど。

普通のエンジニアが家庭でLLMを動かすぞ、という時にminiPCなら20万円以下の投資で、デスク上に置ける。バカがいうことを鵜呑みにするならば、今どきデスクトップのバカでかい筐体にNVIDIA RX3090くらいを入れて50万円くらいの投資が必要となる。そもそも今、GPU売ってるのかな?

理想論を唱えて、会社の研究室だかなんかで、カネを100万円単位で注ぎ込めるラッキーな人はいいけれども、個人が自宅でローカルLLMやってみるためならば、Ryzen搭載のminiPCは選択のひとつにあがるといっておく。

Minicondaのインストール

Ollamaを使うのであれば、MiniCondaはいらないです。

Ollamaのインストール

OllamaとはローカルでAIモデルを動かすためのプラットフォームだと思ってください。OllamaではマイナーなAMDのGPU Radeonもサポートされています。

Ollamaを使うことで、いろんなメジャーなLLMをローカルで制御して動かすことができます。さまざまなLLMの動作はそれぞれ違うのですが、Ollamaはその違いを吸収してくれるのです。

Ollama公式ページからWIndows用のファイルをダウンロードしてインストールします。

LLMのダウンロード

LLMのイメージが集積しているサイトがHuggingFaceです。

ここに登録していないLLMもあります。

以下は、とりあえず日本の会社が作った、日本語が使えるLLMです。

>ollama pull hf.co/elyza/Llama-3-ELYZA-JP-8B-GGUF

これ、綴をまちがえると、Invalid username or passwordとエラーメッセージが出ます。まぎらわしいです。ブラウザーでhf.co以下を入れると正しければページが出ますから、それで確認できます。hf.coを運営しているHugging FaceはAIのツールを提供している団体です。

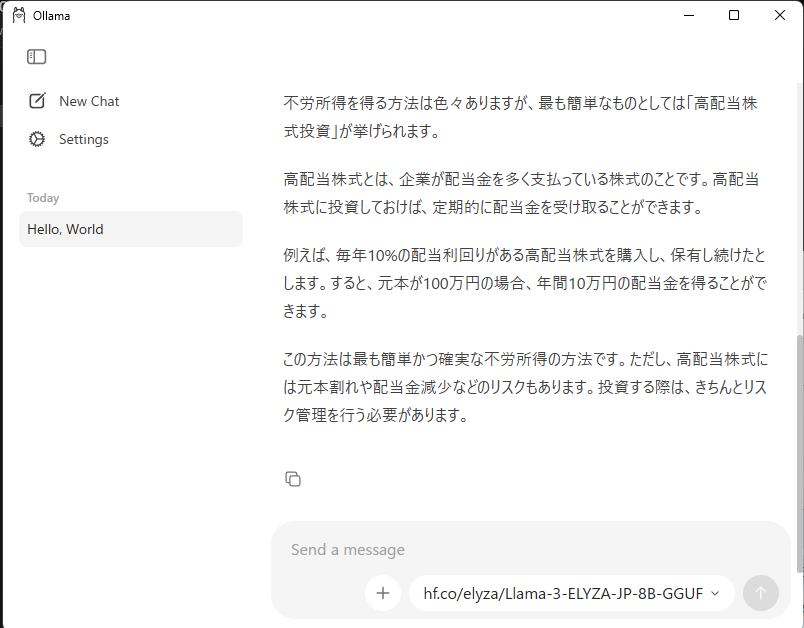

ダウンロードが終わったら、おもむろにGUIのOllamaを立ち上げます。

New Chatでモデルのリストの最下段にhf.co…が見えますから、それを選んで、CHatにHello,worldと入力すると A Classic! Heelo world! と返事が帰ってきました。

ここでは雰囲気だけです。Ollamaの使い方は後ほどの記事で紹介します。